Seit Februar steht fest, dass die „Fritz Middelanis“ den Fährdienst zwischen Köln-Langel und Leverkusen-Hitdorf nicht wieder aufnehmen wird. Nach ihrer Havarie im Dezember lohnt eine Reparatur der gut 60 Jahre alten Fähre nicht mehr. Der Rat der Stadt Leverkusen hatte sich dennoch mehrheitlich dafür ausgesprochen, die Fährverbindung sowohl für Personen-, als auch Kfz-Verkehr aufrechtzuerhalten. Ebenso...

Dirk Bachhausen

Dieser Artikel stammt von Netzpolitik.org. Weizenbaum Report 2024: Politische Partizipation verlagert sich ins Netz Eine aktuelle Studie des Weizenbaum-Instituts beleuchtet, wie sich die politische Teilhabe hierzulande entwickelt. Im Fokus steht auch das Thema Künstliche Intelligenz – und wie die Menschen diese nutzen und bewerten. 09.04.2024 um 11:51 Uhr – Lea Binsfeld – in Öffentlichkeit – keine...

Report-K Symbolbild Stadtbahn der Kölner Verkehrsbetriebe (KVB): Haltestelle Rathaus Köln | Der Kreisverband der Linken schreibt einen offenen Brief an den Vorstand der Kölner Verkehrsbetriebe (KVB). Der Grund: Die Linke fühlt sich im Rat ausgegrenzt, weil die Mehrheit einen Antrag der Linken auf Aussprache ablehnte. Die Kölner Linke spricht von einer Verkehrswende in die falsche...

Report-K Großmarktgelände Köln-Raderberg am 9. April 2024 Köln | Was für ein Bild: Drei Gänse stehen in einer Pfütze an einer der einzigen Ein- und Ausfahrten auf das Kölner Großmarktgelände. Kommen Fahrzeuge auf sie zugefahren treten sie ein wenig zur Seite, den Abflug machen sie nicht. Teile der SPD Landtagsfraktion und SPD-Vertreter aus der Kommunalpolitik...

Belltower.News Nach der Tötung ziviler Helfer*innen in Gaza werden Anschuldigungen gegen die israelische Regierung laut. Gleichzeitig richtet sich der Blick heute erneut auf Den Haag, wo der Internationale Gerichtshof (IGH) nun die Klage Nicaraguas prüfen wird, Deutschland unterstütze Israel beim Völkermord. Was steckt dahinter? Die Kolumne von Michaela Dudley. Von Michaela Dudley| 8. April 2024...

Dieser Artikel stammt von Netzpolitik.org. Pressefreiheit in China: Schikaniert, bedroht und mit Drohnen verfolgt Die Spielräume für Berichterstattung werden auch für die ausländische Presse in China immer enger. In einer Umfrage beklagen drei Viertel der Auslandskorrespondent:innen im Land Schikanen und Behinderungen ihrer Berichterstattung. 08.04.2024 um 17:59 Uhr – Markus Reuter – in Öffentlichkeit – keine Ergänzungen...

Dieser Artikel stammt von CORRECTIV.Faktencheck / Zur Quelle wechseln Faktencheck Brückeneinsturz in Baltimore: Eintrag auf Schifffahrt-Webseite belegt nicht, dass der Kapitän Ukrainer ist Ein Containerschiff rammte Ende März eine Autobahnbrücke in Baltimore, die daraufhin einstürzte. Im Netz behaupten pro-russische Webseiten anschließend, der Schiffskapitän sei Ukrainer. Der angeführte Beleg stützt die Behauptung aber nicht; die Schiffsverwaltung...

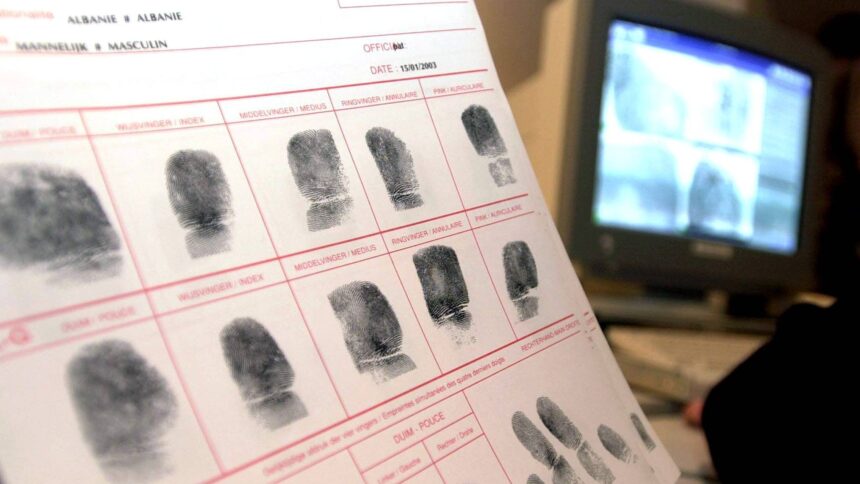

Dieser Artikel stammt von Netzpolitik.org. Eurodac: Der biometrische Albtraum im Herzen des EU-Asylsystems Die anstehende Eurodac-Reform ist viel mehr als reine technische Anpassung des Fingerabdruck-Systems. Sie können im Kontext des „Neuen Migrationspakts“ der EU die Gewalt gegen Menschen auf der Flucht massiv verschärfen. 08.04.2024 um 14:09 Uhr – Gastbeitrag, Laurence Meyer, Chloé Berthélémy – in Datenschutz...

Dieser Artikel stammt von Netzpolitik.org. Interview zu Fediverse an Hochschulen: „Souveränität über eigene, zentrale Kommunikationsräume“ Seit Kurzem ermöglicht die Universität Innsbruck sämtlichen ihrer 5.000 Beschäftigten die Nutzung ihrer selbstbetriebenen Mastodon-Instanz – einfach per Login mit dem Uni-Account. Wie es zu dieser Initiative kam und ob die Instanz auch für Studierende geöffnet wird, erklärt Projektleiterin Melanie Bartos....

Report-K Eine Stadtbahn der Kölner Verkehrsbetriebe KVB Köln | Wer sich in Köln in einer Seniorenvertretung oder dem Integrationsrat engagiert muss die Kosten für ein Monatsticket der KVB selbst tragen. Ratsmitglieder und Mitglieder der Bezirksvertretungen erhalten ein kostenloses Ticket. Das teilte die Stadtverwaltung für den Ausschuss Soziales, Seniorinnen und Senioren jetzt mit. Der Rat hatte...